研究人员将统计和符号人工智能技术结合起来,以加快学习速度和提高透明度。

Researchers combine statistical and symbolic artificial intelligence techniques to speed learning and improve transparency.

Kim Martineau | 麻省理工学院 探索智能

本文由CDA数据分析研究院编译出品,转载需授权

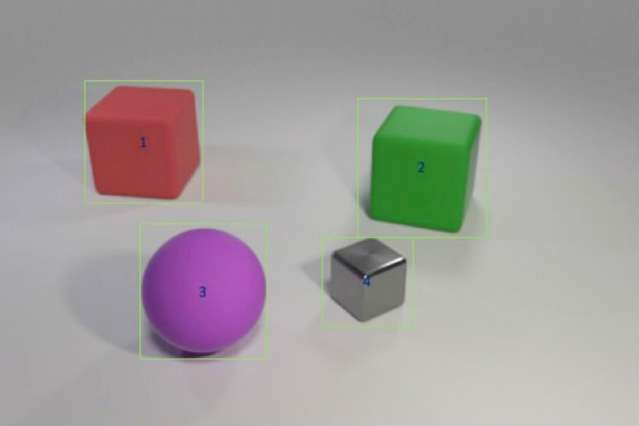

研究人员训练了一个混合人工智能模型来回答这样的问题:“绿色立方体左边的红色物体与紫色哑光物体形状相同吗?”“通过给它提供包含颜色和形状的样本,然后是涉及多对象比较的更复杂的场景。该模型可以将这些知识转移到新的场景中,也比使用部分训练数据的进行训练的最先进的模型要好。

一个从未见过粉红大象的孩子仍然可以描述一只粉红色的大象---“不像电脑”。麻省理工学院(MIT)博士生吴嘉君(Jiajun Wu)说:“计算机是从数据中学习的。”“对机器来说,能够概括和识别你从未见过的东西,比如粉红色的大象-是非常困难的。”

深度学习系统通过挑选出数据中包含的某种统计信息来解释世界。这种机器学习方式现在随处可见,在Facebook上给朋友自动贴上标签,讲述亚历克莎最新的天气预报,并通过谷歌搜索提供有趣的事情。但是统计学习有其局限性。它需要大量的数据,很难解释为什么会是这样的,并且很难将过去的知识应用到新的环境中;比如它无法理解一只粉红而不是灰色的大象。

为了让计算机有能力像我们一样进行推理,人工智能(AI)的研究人员又回到了抽象的或象征性的编程模式中。20世纪50年代和60年代,符号AI将规则和逻辑连接起来,允许机器进行比较,并解释物体和实体之间的联系。符号AI使用较少的数据,记录它所采取的一系列步骤来达成一个决定,当它与统计神经网络的野蛮处理能力相结合时,它甚至可以在复杂的图像理解测试中击败人类。

麻省理工学院IBM沃森人工智能实验室和DeepMind的一组研究人员进行的一项新研究表明,将统计人工智能和符号人工智能结合在一起是有希望的。在麻省理工学院脑和认知科学系以及计算机科学和人工智能实验室的教授吴宇森和 Joshua Tenenbaum 的带领下,研究表明,其混合模型可以学习与物体相关的概念,如颜色和形状,并利用这些知识来解释场景中复杂的物体关系。他们的模型只需要很少的训练数据,没有明确的编程,就可以将模型迁移到更大的场景中,并能回答越来越棘手的问题,甚至比其最先进的同行更好。该小组在5月举行的国际学习代表大会上介绍了其成果。

“孩子们学习概念的一种方式是把文字和图像联系起来,”该研究的主要作者、清华大学的本科生、麻省理工学院的访问学者毛家源说。“能够以同样的方式学习的机器需要的数据少得多,而且能够更好地将其知识迁移到新的场景中。”

雅各布·安德烈亚斯(Jacob Andreas)说,这项研究是回归抽象程序方法的有力论据,他是加利福尼亚大学伯克利分校(University of California at Berkeley)的一名毕业生,今年秋天开始在麻省理工学院(MIT)担任助理教授,并未参与这项工作。他说:“事实证明,诀窍在于增加更多的符号结构,并向神经网络提供一种世界的表示,这种世界被划分为对象和属性,而不是给它提供原始图像。”“这项工作让我们了解在语言学习成为可能之前,机器需要了解什么。”

研究小组将他们的模型训练在与相关问题和答案配对的图像上,这是斯坦福大学开发的CLEVR图像理解测试的一部分。随着模型的学习,问题越来越难回答,“物体的颜色是什么?”“到”绿色圆柱体右侧有多少个物体,与蓝色小球的材质相同吗?“一旦掌握了对象级的概念,模型就开始学习如何将对象及其属性相互关联。

像其他混合人工智能模型一样,麻省理工的工作就是将任务分解。神经网络的感知模块对每幅图像中的像素进行处理,并绘制出物体的地图。语言模块,也由神经网络组成,从每个句子中的单词中提取意义,并创建符号程序或指令,告诉机器如何回答问题。第三个推理模块在现场运行符号程序并给出答案,当模型出错时更新模型。

团队方法的关键是一个感知模块,它将图像转换为基于对象的表示,使程序更容易执行。同样独特的是他们所说的课程学习,或选择性地训练模式的概念和场景,逐步增长的难度。事实证明,以合乎逻辑的方式而不是随意地输入数据有助于模型更快地学习,同时提高准确性。

一旦模型有了坚实的基础,它就可以解释新的场景和概念,以及越来越难的问题,这几乎是完美的。被要求回答一个不熟悉的问题,比如,“大黄色物体的形状是什么?”它的训练数据比斯坦福大学和附近的麻省理工林肯实验室的同行要少,但是效果上是更好的。

当其他模型接受了70000张图片和700000个问题的完整CLEVR数据集进行训练时,MIT-IBM模型使用了5000张图片和100000个问题。由于模型建立在先前学习的概念之上,它吸收了每个问题的基础程序,所以加快了训练过程。

虽然在统计上,深度学习模型现在已经嵌入日常生活中,但它们的决策过程中的大部分仍然隐藏在视野之外。由于缺乏透明度,很难预测系统易受操纵、错误或偏差的影响。添加一个符号层可以打开黑匣子,解释混合人工智能系统日益增长的兴趣。

林肯实验室研究员大卫·马斯卡卡(David Mascharka)说:“将任务分解,让程序完成一些工作,是将可解释性构建成深度学习模型的关键。”他的混合模型“透明设计网络”(Transparency by Design Network)是麻省理工学院-IBM研究的基准。

MIT-IBM团队现在正致力于改进模型在真实照片上的性能,并将其扩展到视频理解和机器人操作。这项研究的其他作者分别是麻省理工学院-IBM沃森人工智能实验室和DeepMind的研究员庄根(Chuang Gan)和普希梅特·科利(Pushmeet Kohli)。

原标题:Teaching machines to reason about what they see